Che l’intelligenza artificiale sia una gallina dalle uova d’oro ormai lo hanno capito anche i sassi… il problema è che come già era scritto nel Vangelo “Molti sono i chiamati ma pochi gli eletti ( Matteo 21,23-27)” o per dirla in maniera più moderna individuare quelle aziende che potrebbero affiancare gli attuali Gorilla nell’AI (nvidia e microsoft fra tutti). Gia’ parecchi spunti li ho raccolti nella prima parte di questa discussione che potete trovare QUI ma continuo nella mia selezione di articoli che reputo significativi.

30/10/24 Briefing.com: Advanced Micro Devices scivola dopo la lieve guidance sui ricavi del Q4; La domanda di IA è ancora robusta (AMD)

Advanced Micro (AMD -9%) scivola oggi poiché i suoi ricavi del Q3 sono stati insufficienti per superare un’altra lieve prospettiva di vendita trimestrale. È stato un altro trimestre turbolento per l’intelligenza artificiale, con il segmento principale dei data center di AMD che ha più che raddoppiato i ricavi anno su anno per il secondo trimestre consecutivo. La crescita fuori misura legata all’intelligenza artificiale ha spinto AMD ad aumentare nuovamente le sue previsioni di vendita di data center AI per il FY24 di 0,5 miliardi di dollari a 5,0 miliardi di dollari.

Tuttavia, il mercato era preparato per un’impressionante crescita legata all’intelligenza artificiale, in particolare dopo che il fornitore di AMD, Taiwan Semi (TSM), ha fornito eccellenti numeri del Q3 alimentati dall’intelligenza artificiale all’inizio di questo mese. Nel frattempo, al di fuori della costante domanda dei clienti, che ha ancora rallentato sequenzialmente, AMD ha subito ulteriori cali delle vendite anno su anno nei suoi segmenti Gaming ed Embedded, sottolineando i venti contrari macroeconomici ostinati. Di conseguenza, gli acquirenti non stanno entrando in azione oggi, mantenendo le azioni di AMD all’interno della gamma.

- L’intelligenza artificiale è rimasta l’headliner nel terzo trimestre, portando un fatturato dei data center del 122% su base annua a 3,5 miliardi di dollari. I trimestri consecutivi di crescita di oltre il +100% hanno portato il segmento a comprendere oltre la metà dei giri totali di AMD, rispetto a solo un quarto del fatturato totale di due anni fa. La piattaforma CPU EPYC di AMD, utilizzata per alimentare i servizi cloud generali, come Office 365 (MSFT) e Netflix (NFLX), ha avuto un forte successo. Tuttavia, la superstar è stata la piattaforma GPU MI300X di AMD, che alimenta le numerose istanze relative all’intelligenza artificiale.

- Durante la conferenza, il management ha discusso dell’insaziabile appetito per l’intelligenza artificiale, facendo riferimento a grandi aziende tecnologiche come Microsoft e Meta Platforms (META) che si sono aggiudicate gli acceleratori MI300X di punta di AMD.

- Guardando al futuro, AMD è entusiasta dei vantaggi competitivi delle sue prossime piattaforme. Ad esempio, l’azienda ha notato che il suo MI325X, che sta riscontrando un elevato interesse da parte dei clienti, offre prestazioni di inferenza fino al 20% superiori rispetto al chip H200 di NVIDIA (NVDA). L’inizio delle consegne di produzione dell’MI325X è previsto per il quarto trimestre, con un’ampia disponibilità nel primo trimestre del 25. Inoltre, la serie MI350 di nuova generazione di AMD è sulla buona strada per un lancio nel 2H25, con la serie MI400 che procede verso un lancio nel 2026.

- Tuttavia, nel frattempo, gli altri segmenti di AMD non stanno raccogliendo lo stesso entusiasmo. Il giro di affari del segmento di clientela, che si concentrano sui PC, sono aumentati del 29% su base annua a 1,9 miliardi di dollari, sostenuti da una forte domanda di processori Zen 5 Ryzen nonostante le recenti recensioni sfavorevoli dei clienti. I ricavi dei giochi sono diminuiti nel terzo trimestre, scendendo del 69% su base annua a 462 milioni di dollari, in gran parte a causa di un calo dei giri semi-personalizzati, sottolineando la scarsa domanda di console di gioco. L’embedded è diminuito del 25% su base annua poiché i clienti hanno continuato ad adeguare i livelli di inventario.

- Queste debolezze si sono rivelate un freno alle prospettive di AMD per il Q4, prevedendo un fatturato di 7,2-7,8 miliardi di dollari, il cui punto medio era semplicemente in linea con il consenso. AMD non ha emesso una guidance trimestrale ottimista dal 2022. Data la domanda costante di intelligenza artificiale, il mercato ha cercato una guida più vivace.

In conclusione, mentre l’intelligenza artificiale rimane calda, la temperatura tiepida degli altri segmenti di AMD continua a pesare sulla guidance sui ricavi trimestrali. Tuttavia, l’embedded si sta gradualmente riprendendo, mentre si prevede che il gaming porterà a una crescita sequenziale nel quarto trimestre. Con la domanda di intelligenza artificiale che dovrebbe rimanere robusta, AMD è ben posizionata per riaccendere l’interesse per le sue azioni.

29/10/24 Bloomberg: Il CEO di Arm ritiene che l’intelligenza artificiale trasformerà il mondo molto più velocemente di Internet

Meno di due anni dopo essere diventato amministratore delegato di Arm Holdings Plc, Rene Haas ha guidato il progettista di chip britannico alla più grande offerta pubblica iniziale del 2023 al mondo, raccogliendo 4,87 miliardi di dollari. Da allora, le azioni sono più che raddoppiate, valutando la società con sede a Cambridge a quasi 150 miliardi di dollari.

Haas mira a mettere Arm, che progetta chip per giganti della tecnologia come Apple Inc. e Samsung Electronics Co., in prima linea nell’intelligenza artificiale. La battaglia sulla proprietà intellettuale ha innescato un’escalation di controversie legali con il partner di lunga data Qualcomm Inc.

Il dirigente californiano ha parlato con Bloomberg a Londra prima che l’ultimo episodio della faida con Qualcomm diventasse pubblico. Il 62enne ha parlato dello sviluppo dell’intelligenza artificiale molto più veloce di Internet, dello sviluppo unidirezionale dell’industria automobilistica e dei libri che lo aiutano a prendere decisioni. La trascrizione è stata modificata per brevità.

Bloomberg: La vostra strategia è quella di alimentare la rivoluzione dell’intelligenza artificiale. Quali sono le cose che potrebbero intralciare?

Haas: Uno dei veri limiti per la nostra crescita è il talento. La nostra opportunità è ampia. Siamo nel settore degli smartphone, dei PC, delle fotocamere, delle automobili, dei data center e tutte queste soluzioni richiedono sempre più innovazione. Ho bisogno di più ingegneri. Stiamo cercando di espanderci a livello globale.

D: Le notizie sull’intelligenza artificiale possono dare un colpo di frusta agli investitori. Tagliando gli alti e bassi di Nvidia, ASML e simili, sei più eccitato ora di quanto non lo fossi un anno fa?

R: Al 100%. In effetti, sono sorpreso che si sia mosso tanto velocemente quanto si è mosso. Ho avuto la possibilità di vedere in anteprima uno dei più recenti modelli di OpenAI, che ora pensa e ragiona. Questo è un grande salto. Se pensi a quello che ChatGPT era stato in precedenza, setaccia Internet e ti dà una risposta davvero bella ed elegante basata sulle ricerche. Ma non si tratta di ragionare. I nuovi modelli possono farlo.

D: I data center sono in piena espansione, ma ci sono preoccupazioni per il loro fabbisogno energetico. Qual è la soluzione? Più energia o chip più efficienti?

R: Abbiamo bisogno di entrambi. Abbiamo bisogno di chip molto più efficienti dal punto di vista energetico, motivo per cui Arm sta guadagnando molte quote nel segmento dei data center. Detto questo, credo che avremo bisogno di sempre più accesso all’energia, punto, perché non generiamo abbastanza elettricità. Quindi, ci sarà bisogno di una combinazione di solare, batteria, eolico, forse anche nucleare.

Questi grandi data center che eseguono l’addestramento per gli algoritmi di intelligenza artificiale, generano un’enorme quantità di consumo di energia. Non siamo neanche lontanamente vicini al limite di quanto siano intelligenti questi modelli di intelligenza artificiale.

D: Hai detto che l’intelligenza artificiale ora è come Internet a metà degli anni ’90. Quindi, tra 30 anni, l’intelligenza artificiale potrebbe essere quasi irriconoscibile. Come potrebbe essere questo futuro?

R: La differenza, direi, tra l’Internet del 1990 ad oggi e l’IA di 30 anni dopo è che non ci vorrà così tanto tempo. Accadrà molto, molto più velocemente, probabilmente da cinque a 10 anni.

Si tratterà semplicemente di aiutare l’intelligenza artificiale a fare cose come la ricerca sui farmaci. Se si pensa ai tassi di fallimento della ricerca sui farmaci: 95% di fallimento, da 10 a 12 anni per sviluppare un nuovo farmaco. L’intelligenza artificiale sarà in grado di ridurre questi tempi, potenzialmente della metà. Sarà molto, molto drammatico.

D: L’industria automobilistica si è scontrata con venti contrari. Siete preoccupati per questo, o la volatilità è irrilevante perché il quadro generale è ancora quello delle auto con più chip?

R: Sicuramente quest’ultimo. Questo settore sta attraversando una trasformazione per la prima volta negli ultimi 75 anni. Dal motore a combustione all’elettrico, si tratta di una rivoluzione gigantesca se si tratta di come vengono progettate le auto, di come vengono prodotte e, in ultima analisi, di come si guida il prodotto. Tutte le case automobilistiche con cui parli, che si tratti di Mercedes, BMW, Toyota, Stellantis o Ford, vogliono muoversi in questo settore, ma è molto impegnativo.

D: Quando pensa alle sue operazioni a livello globale, vede il ruolo della Cina diventare più grande, più piccolo o rimanere lo stesso?

R: Oggi, la Cina rappresenta circa il 15% della nostra attività. Vedo che rimarrà più o meno lo stesso. Ci sono mercati in cui la Cina continua a innovare e a essere leader, come i veicoli elettrici. Questi veicoli sono tutti basati su Arm. E la Cina sta ovviamente facendo molto nel settore degli smartphone con Xiaomi, Vivo, OPPO e marchi del genere. Questi sono ottimi mercati per noi. Ma anche il resto del mondo sta innovando in modo piuttosto aggressivo.

D: L’industria dei semiconduttori è stata coinvolta nella geopolitica. Le competenze necessarie per gestire un’attività di chip sono cambiate nel tempo?

R: Penso di sì. 10 anni fa, la quantità di interazione che i miei predecessori avevano con i leader di governo non era della portata attuale. Incontro persone tutto il tempo, che sia nel Regno Unito, negli Stati Uniti, nell’UE o in Cina, e parlo molto di politica, strategia, ecc. Due fattori lo spingono: la geopolitica è molto più complicata e ci sono molte cose che riguardano il controllo delle esportazioni. Ma anche il nostro settore è tornato ad essere importante.

D: E infine… C’è qualcosa che hai letto, guardato o ascoltato che ti ha lasciato un’impressione?

R: Volo molto, quindi sono un drogato di podcast. Mi piace BG2, il podcast di Brad Gerstner. Lo ascolto molto. Ascolto i podcast di Bloomberg. E noi abbiamo i nostri, era un po’ snervante essere un reporter.

Per quanto riguarda la lettura, ho dai 10 ai 15 libri sul mio Kindle. Mi piacciono i libri di storia, e in realtà sto leggendo un libro intitolato “The Upside of Disruption”, che parla un po’ del caos e di come funzionano le cose. Devo leggere di nuovo “Too Big to Fail” di Andrew Ross Sorkin, solo per guardare a come vengono prese le decisioni in tempi di crisi in aree senza precedenti.

09/10/24 Barron’s: Jensen Huang sul futuro dell’IA e sul più grande vantaggio di Nvidia

Supremazia del software.Nvidia

Le azioni di Nvidia stanno di nuovo correndo con il valore di mercato del produttore di chip che raggiunge i 3,3 trilioni di dollari. Da un giorno all’altro, Nvidia potrebbe superare Apple come l’azienda più preziosa del mondo.

L’ultima spinta a Nvidia arriva da produttori di server AI Super Micro Computer e Hon Hai che hanno pubblicizzato la continua domanda di hardware AI. Anche il CEO di Microsoft si sta vantando sui social media su quanto velocemente la sua azienda stia adottando gli ultimi chip di Nvidia. (Inserzione grafica-processing units di Nvidia sono adatte per i calcoli paralleli necessari per l’IA.)

Mentre Nvidia si crogiola nel suo successo, i giorni più luminosi dell’azienda potrebbero ancora essere davanti. Il CEO Jensen Huang è ottimista sul fatto che il produttore di GPU possa continuare a migliorare le prestazioni dell’hardware AI, portando a maggiori progressi nelle capacità di intelligenza artificiale.

In effetti, dice Huang, non abbiamo ancora visto nulla in termini di innovazione dell’IA.

“Stiamo cercando di farlo andare più veloce”, ha detto Huang durante una conversazione con il CEO di Arm Rene Haas. La discussione è arrivata nell’episodio di debutto di un nuovo podcast ospitato da Arm chiamato Tech Unheard .

Ci sono stretti legami tra Huang e Haas e le loro aziende. Prima di entrare in Arm, Haas ha trascorso sette anni lavorando per Huang come direttore generale del business dei prodotti informatici di Nvidia. Nel 2020, Nvidia ha accettato di acquistare Arm per 40 miliardi di dollari. L’accordo è fallito per l’opposizione dell’antitrust.

Quella familiarità era evidente nella conversazione tra i due dirigenti del chip. Hanno sbarrato sulla loro storia condivisa con alcuni dialoghi rivelatori mescolati.

Huang ha detto a Haas che Nvidia avrebbe guidato prestazioni aggiuntive, senza ulteriori requisiti di energia e costi, andando oltre la GPU, progettando l’intero sistema informatico, dalla rete e dagli switch al software e ad altri chip.

“Vogliamo ridurre il costo in modo da poter fornire questo nuovo tipo di inferenza di ragionamento con lo stesso costo e reattività del passato”, ha detto Huang.

Ha aggiunto che i chatbot AI sarebbero in grado di ricercare idee, ragionare e riflettere sulle loro risposte in modo più approfondito passando attraverso migliaia di calcoli di pensiero prima di raggiungere una conclusione. “La qualità delle risposte sarà molto migliore”.

Ma più di prima, Huang ha anche parlando del potere del software. È un’altra area di forza per Nvidia, ma in cui l’azienda non ottiene molto credito.

Nel podcast di questa settimana, Huang ha sottolineato l’importanza del software e la sua compatibilità con l’hardware futuro.

“Il software che hai sviluppato per i cluster di ieri come Hopper verrà eseguito su Blackwell, e quel software verrà eseguito su Rubin [la futura architettura GPU di Nvidia]”, ha detto. “Questa compatibilità architettonica è davvero molto vitale perché l’investimento dell’industria sul software è mille volte maggiore dell’hardware… tutto il software che scrivi oggi migliorerà domani”.

Huang ha notato che una volta che il software viene messo in produzione, raramente muore all’interno delle aziende. L’ecosistema di programmazione software di Nvidia, CUDA, è potente perché qualsiasi nuovo software può essere eseguito su una base installata di GPU Nvidia che è già nelle centinaia di milioni.

Nonostante la reputazione di Nvidia come azienda di hardware e chip, più della metà degli ingegneri dell’azienda lavora sul software. Questa è probabilmente una sorpresa per molti investitori e un motivo in più per cui le azioni Nvidia hanno spazio per correre.

30/09/24 Barron’s; Le Azioni Di Constellation Sono Raddoppiate Quest’Anno. Il motivo per continuare a volare.

DiEmily DattiloRistampe

Le azioni di Constellation Eneergy stanno avendo un grande anno e possono continuare a salire, dice KeyBanc Capital Markets.

Gli analisti guidati da Sophie Karp hanno aumentato il loro obiettivo di prezzo delle azioni sulla società energetica a 279 dollari da 265 dollari e hanno ribadito un rating di sovrappeso sulle azioni. Il titolo ha chiuso a 257 dollari venerdì.

Il nuovo obiettivo di prezzo si basa su una valutazione di 30 volte gli utili per azione che Constellation dovrebbe produrre nel 2025, riflettendo che gli investitori ora hanno una visione più chiara di quanto velocemente i profitti potrebbero crescere a lungo termine, hanno scritto gli analisti. Storicamente, le azioni di Constellation sono state scambiate tra 12 e 28 volte gli utili.

All’inizio di questo mese, la società ha annunciato che essa e Microsoft avevano stipulato un accordo di acquisto di 20 anni per l’energia dal sito nucleare di Three Mile Island in Pennsylvania. Barron ha riferito che la società energetica riceverà un compenso con un premio alla tariffa corrente per l’elettricità nell’area, mentre Microsoft otterrà energia senza emissioni di carbonio per gestire i suoi data center.

“Crediamo che questo sia stato un catalizzatore importante nel dimostrare il valore della generazione nucleare nell’era dell’IA e ci aspettiamo che lo slancio continui”, hanno scritto gli analisti.

Le azioni di Constellation sono aumentate dell’1,3% a 260,25 dollari lunedì. Il titolo è più che raddoppiato quest’anno, con un guadagno del 123%.

Scrivi a Emily Dattilo a emily.dattilo@dowjones.com

25/09/24 Briefing.com: Il forte rapporto utili di Micron ricorda al mercato che si tratta di un leader fra i partecipanti all’intelligenza artificiale

A seguito di un deludente rapporto sugli utili del 3Q24 alla fine di giugno in cui ha semplicemente stimato le entrate del quarto trimestre in linea con le stime degli analisti, le aspettative alle stelle e il prezzo delle azioni, per il produttore di chip di memoria Micron (MU) erano crollati. Dopo la chiusura di ieri sera, tuttavia, MU ha rivelato che era prematuro gettare la spugna poiché la robusta domanda di server AI ha alimentato un’impressionante performance beat-and-raise Q4 che non solo sta catapultando le azioni MU in forte più in alto, ma sta anche alla base della forza in tutto lo spazio dei semiconduttori.

All’indomani di quel rapporto sugli utili del terzo trimestre, la narrazione principale che circondava MU era che mentre le sue prospettive di crescita basate sull’intelligenza artificiale erano solide, grazie al crescente slancio nel suo mercato dei data center, l’esposizione dell’azienda ai mercati finali più lenti di PC e smartphone l’avrebbe frenata. I livelli di inventario sono stati elevati, specialmente all’interno della base di clienti di PC di MU, esercitando una pressione al ribasso sui volumi di DRAM e le tendenze della spesa soft dei consumatori hanno pesato sul mercato degli smartphone.

Sebbene quella narrazione fosse in parte corretta – i mercati di PC e smartphone rimangono davvero in una pausa – non è riuscita a cogliere quanto sia forte il business dell’IA per MU, come illustrato dai seguenti punti dati:

- Il mix di entrate del data center dell’azienda ha raggiunto un livello record nel 2024, ma sta solo grattando la superficie in termini di potenziale contributo alle entrate. MU si aspetta che il mercato totale indirizzabile (TAM) per i suoi chip di memoria ad alta larghezza di banda (HBM) esploda a oltre 25,0 miliardi di dollari nel 2025, rispetto ai 4,0 miliardi di dollari di quest’anno.

- Il CEO Sanjay Mehrotra ha ribadito che i chip HBM sono esauriti per i calendari 2024 e 2025 e che l’azienda sta facendo buoni progressi nell’aumento della sua capacità di produzione. MU sta costruendo un nuovo fab in Idaho, che dovrebbe essere operativo nel 2025, e sta anche lavorando attraverso il processo di autorizzazione per un’altra struttura a New York.

- Oltre a HBM, il portafoglio di data center dell’azienda include anche prodotti D5 e LP5 ad alta capacità e soluzioni SSD. MU si aspetta che ciascuna di queste categorie di prodotti generi più miliardi di dollari di entrate nell’anno fiscale 25.

- Rafforzato dai fattori di cui sopra, la guida alle entrate del primo trimestre 25 dell’azienda di 8,50-8,90 miliardi di dollari ha facilmente battuto le aspettative con il punto medio dell’intervallo di orientamento pari a una crescita anno/anno dell’85%.

La ciliegina sulla torta è che MU prevede che la crescita delle unità PC acceleri nella parte posteriore di CY25 man mano che il ciclo di sostituzione del PC prende slancio con il lancio di nuovi PC AI e del sistema operativo Windows 12. Questo, a sua volta, dovrebbe portare a livelli di inventario più sani presso i produttori di PC, fornendo un altro catalizzatore per i volumi e i prezzi della DRAM. La linea di fondo, però, è che il rapporto beat-and-raise di MU ha rimesso l’azienda sulla mappa come un giocatore leader nel campo dell’ intelligenza artificiale.

23/09/24 NYTime: Può l’ A.I. essere un bluff? Uno scettico di Wall Street suona l’allarme.

Jim Covello, capo della ricerca azionaria di Goldman Sachs, ha avvertito che costruire troppo di ciò di cui il mondo non ha bisogno “in genere finisce male”.

Mentre l’auto di Jim Covello correva sull’autostrada 101 da San Jose a San Francisco questo mese, ha contato i cartelloni pubblicitari sull’intelligenza artificiale. I quasi 40 cartelli che ha superato, tra cui uno che promuoveva qualcosa chiamato Writer Enterprise AI e un altro per Speech AI, erano nuove prove, pensò, di una bolla economica.

“Non molto tempo fa, erano tutti cripto”, ha detto Covello dei cartelloni pubblicitari. “E ora sono tutti A.I.”

Covello, capo della ricerca azionaria presso Goldman Sachs, è diventato il principale scettico dell’IA di Wall Street. Tre mesi fa, ha scosso i mercati con un documento di ricerca che ha sfidato se le aziende avrebbero visto un rendimento sufficiente su quello che secondo alcune stime potrebbe essere di 1 trilione di dollari in spesa per A.I nei prossimi anni. Ha detto che l’intelligenza artificiale generativa, che può riassumere il testo e scrivere il codice software, ha commesso così tanti errori che era discutibile se avrebbe mai risolto in modo affidabile problemi complessi.

Il documento di Goldman è arrivato giorni dopo che un partner di Sequoia Capital, una società di venture capital, ha sollevato domande simili in un post sul blog sull’IA. Il loro scetticismo ha segnato un punto di svolta per le azioni correlate all’IA, portando ad un ripensamento del settore più caldo di Wall Street.

Il paniere di azioni A.I. di Goldman, che è gestito da un braccio separato dell’azienda e comprende Nvidia, Microsoft, Apple, Alphabet, Amazon, Meta e Oracle, è diminuito del 7 per cento dal suo picco del 10 luglio, mentre investitori e leader aziendali discutono se l’IA possa giustificare i suoi costi sbalorditivi.

La pausa è arrivata all’inizio della corsa agli armamenti A.I. L’industria tecnologica ha una storia di grandi spese per realizzare transizioni tecnologiche, come ha fatto durante le rivoluzioni dei personal computer e di Internet. Quei build-out hanno attraversato cinque anni o più prima che ci fosse un ritorno nei conti.

Ma il signor Covello, 51 anni, ha esperienza con i boom e i fallimenti tecnologici. Ha seguito lo scoppio della bolla dot-com come analista di semiconduttori ed è stato sfregiato nel vedere i colleghi perdere il lavoro. Più recentemente, il veterano di Goldman è entrato a far parte di un team interno che ha valutato i servizi di IA per l’azienda. Ha detto che i servizi che ha recensito erano costosi, ingombranti e non “abbastanza intelligenti da rendere i dipendenti più intelligenti”.

La storia del settore ha portato alcune persone a dire che l’invito alla cautela del signor Covello è prematuro. Poco dopo la pubblicazione del documento di Goldman, George Lee, co-responsabile dell’attività di consulenza geopolitica dell’azienda, ha sfidato il signor Covello in un’e-mail, dicendo che l’IA era pronta a risparmiare tempo ai lavoratori e migliorare la loro produttività. Il signor Lee lo ha esortato ad essere paziente.

“L’impatto a lungo termine dei cambiamenti di piattaforma è che le applicazioni emergono nel tempo man mano che quella tecnologia viene perfezionata, resa più facilmente disponibile, resa più economica”, ha detto Lee in un’intervista, parlando dell’e-mail.

I clienti di Goldman hanno chiesto di saperne di più. Su loro richiesta, l’azienda ha iniziato a ospitare dibattiti privati di toro e orso con il signor Lee, come il toro, delineando il suo ottimismo sull’IA, e il signor Covello, come l’orso, spiegando il suo pessimismo.

La conversazione era in ritardo, ha detto Jim Morrow, amministratore delegato di Callodine Group, un cliente di Goldman con sede a Boston. “A.I. aveva catturato lo zeitgeist del mercato”, ha detto. “Avere qualcuno di un’azienda come Goldman suonare il campanello e dire: ‘Ehi, non diventerà realtà nel modo in cui tutti pensano’ ha fatto fare domande importanti a persone su ciò che stava realmente accadendo”.

Il signor Covello è nato per essere uno scettico. Prima di partire per la Georgetown University, dove sarebbe diventato la prima persona della sua famiglia di Filadelfia ad andare al college, suo padre gli chiese se una laurea quadriennale potesse mai giustificare il suo costo. Poi, come prima base nella squadra di baseball dell’università, ha usato lo stesso occhio scettico nella scatola del battitore mentre aveva una media di un rispettabile .270.

Nel 2000 è entrato a far parte di Goldman Sachs come analista tecnologico. Quell’estate, l’azienda si è riunita in un vigneto nella Napa Valley per un’entusiastica convention aziendale sull’industria tecnologica. Ma il boom di Internet, che era già stato al culmine, ha iniziato a crollare nei mesi successivi.

Alcune aziende come Google e Amazon sono sopravvissute e sono diventate favolosamente ricche, ma il signor Covello si è fissato sulla carneficina. “È stato un momento molto spaventoso”, ha detto. “Non sapevo se avrei ancora avuto un lavoro”.

Il signor Covello ha mantenuto il suo lavoro. All’epoca, Goldman stava riducendo i suoi costi sostituendo gli analisti esperti con dipendenti più giovani. Ha promosso Covello come suo principale analista di semiconduttori nel 2001 e lo ha elevato a capo della ricerca azionaria globale nel 2021.

Dopo il rilascio di ChatGPT nel 2022, l’industria tecnologica ha iniziato a confrontare l’arrivo di A.I. con l’alba dell’Internet pubblico. Il confronto ha attirato l’attenzione del signor Covello. “Non è questo per cui chiunque dovrebbe fare il tifo”, ha detto, ricordando i milioni di posti di lavoro che sono stati persi.

Per creare attività di IA, gli esperti hanno previsto che 1 trilione di dollari sarebbero stati spesi in data center, servizi pubblici e applicazioni. Il signor Covello pensava che quei costi rendessero impossibile per l’industria risolvere a basso costo i problemi del mondo reale, che è ciò che le società di Internet facevano decenni fa.

Come membro del gruppo di lavoro di Goldman sull’IA, ha esaminato un servizio che utilizzava l’IA generativa per aggiornare automaticamente i fogli di calcolo degli analisti con i risultati finanziari delle aziende. Ha detto che ha fatto risparmiare ai suoi analisti circa 20 minuti di tempo per azienda, ma è costato sei volte di più.

La voce dello scetticismo del signor Covello si diffuse nell’azienda. Allison Nathan, che cura un rapporto di ricerca mensile chiamato “Top of Mind”, stava pianificando un numero su A.I. Su raccomandazione di un collega, ha incontrato il signor Covello.

“Per circa 35 minuti, sono stata ammutolita dalla sua narrazione e dalle sue opinioni”, ha detto.

La signora Nathan ha deciso di intervistare il signor Covello per il rapporto. La conversazione ha contribuito a inquadrare il titolo del rapporto di 31 pagine, “Gen AI: Troppa spesa, troppo poco beneficio?”

Il signor Covello ha sfidato l’idea che i costi dell’IA sarebbero diminuiti, osservando che i costi sono aumentati per alcune tecnologie sofisticate come le macchine che producono semiconduttori. Ha anche criticato le capacità di A.I.

“Costruire cose per cui il mondo non ha bisogno, o per cui non è pronto, in genere finisce male”, ha detto.

Alla conferenza tecnologica annuale di Goldman questo mese a San Francisco, l’azienda ha messo il signor Covello e il signor Lee davanti a poche centinaia di persone per spiegare le loro opinioni divergenti sull’IA. Il signor Covello si è concentrato sulle carenze della tecnologia, citando un articolo di Business Insider su un’azienda farmaceutica che ha cancellato i suoi servizi Microsoft A.I. dopo aver trovato le capacità alla pari con “presentazioni della scuola media”.

Il signor Lee scosse la testa. Ha evidenziato un documento dell’Università di Princeton che ha scoperto che l’IA ha aiutato 5.000 sviluppatori in 100 aziende a raggiungere un aumento della produttività del 20%.

“Non è perfetto”, ha detto il signor Lee. Ma ha aggiunto: “Le persone stanno raccogliendo un po’ di risparmio sulla produttività”.

Alcune persone tra il pubblico si sono chieste se Goldman stesse coprendo le sue basi mettendo in luce il suo pessimista interno di IA in una conferenza guidata da evangelisti di IA come Jensen Huang, l’amministratore delegato di Nvidia, il principale produttore mondiale di chip di IA. Ma molte persone hanno considerato il dibattito costruttivo.

“Era una versione aggiornata della domanda: ‘Se lo costruisci, verranno?'” ha detto David Readerman, gestore di portafoglio presso Endurance Capital Partners.

Il signor Covello prevede che il boom dell’IA perderà slancio quando le aziende che stanno adottando la tecnologia taglieranno la spesa dopo che i loro profitti sono crollati. Non pensa che questo farà scenare un’altra recessione delle dot-com. Ma ogni giorno, sta rivalutando la sua posizione.

“Quando hai una visione che è un po’ fuori dal consenso generale, vivi in questo tipo di stato costante di paranoia che A.I. sarà grande come tutti pensano che sia”, ha detto. “Quindi sono sinceramente alla ricerca dei miei punti ciechi ogni singolo giorno. Dove potrei sbagliarmi?”

13/09/24 Briefing.com: Oracle

L’impennata di Oracle continua mentre le sue prospettive di crescita nel cloud e nell’intelligenza artificiale sono sotto i riflettori (ORCL)

Una settimana molto buona per Oracle (ORCL) si è trasformata in una ancora migliore dopo che Bloomberg ha riferito che la società di database e software cloud ha alzato la sua guidance sui ricavi per il FY26 ad almeno 66,0 miliardi di dollari durante una riunione degli analisti finanziari di ieri. Le prospettive rialziste, che dipendono in gran parte dalla robusta domanda all’interno del business delle infrastrutture cloud (OCI) di ORCL, arrivano sulla scia di un solido rapporto sugli utili del Q1 che ha caratterizzato un EPS migliore e un’impressionante crescita degli obblighi di performance rimanenti (RPO) del 53%. Alimentate da questi due catalizzatori, le azioni di ORCL sono aumentate del 20% questa settimana.

- Guardando più lontano all’orizzonte, ORCL ha affermato che 104 miliardi di dollari di entrate nel FY29 sono un obiettivo raggiungibile man mano che espande la sua attività di infrastruttura cloud e capitalizza su una quantità sempre crescente di casi d’uso dell’intelligenza artificiale. Quando si pensa ai principali fornitori di cloud, vengono subito in mente i tre hyperscaler – Microsoft (MSFT), Google (GOOG) e Amazon Web Services (AMZN), ma ORCL sta diventando un attore molto formidabile nello spazio.

- In alternativa ai tre grandi hyperscaler, OCI fornisce ai clienti macchine virtuali e server per eseguire carichi di lavoro complessi e fornisce loro una varietà di offerte di storage in grado di gestire enormi volumi di dati. Inoltre, OCI ha lanciato nuovi strumenti di intelligenza artificiale, come OCI Vision e Oracle Machine Learning, che aiutano le aziende a sfruttare l’analisi e l’automazione dei dati. Infine, OCI ospita anche i prodotti applicativi cloud dell’azienda, inclusi i prodotti Human Capital Management (HCM) e Enterprise Resource Planning (ERP).

- Quando ORCL ha pubblicato i risultati del Q1 lunedì sera, ha riferito che i ricavi dell’infrastruttura cloud sono aumentati del 45% su base annua a 2,2 miliardi di dollari, sostenuti da un aumento del 56% dei ricavi da consumo OCI. In effetti, la crescita sarebbe stata ancora più forte se ORCL avesse avuto una maggiore capacità. A tal proposito, l’azienda sta pianificando di raddoppiare il suo capex nel FY25 rispetto al FY24 a sostegno della sua creazione di altre 77 regioni cloud. Per un po’ di contesto, ORCL ha attualmente 85 aree cloud operative.

- MSFT, GOOG e AMZN non sono solo concorrenti di ORCL, ma sono anche clienti in quanto eseguono il software di database di ORCL sulle loro piattaforme cloud. Oltre ai risultati e alle indicazioni del Q1, ORCL ha anche annunciato un nuovo accordo con Amazon Web Services (AWS), che consente ai clienti AWS di accedere a Oracle Autonomous Database su un’infrastruttura dedicata e a Oracle Exadata Database Service all’interno di AWS.

Il lungo viaggio da sviluppatore di software di database on-premise a società di software e infrastrutture cloud è stato a volte difficile per ORCL e i suoi azionisti, ma la sua transizione è in pieno svolgimento ora e una crescita più forte è finalmente una realtà.

10/09/24 Briefing.com: Palantir Technologies raggiunge i migliori livelli dall’inizio del 2021 dopo l’inclusione in S&P 500 (PLTR)

Le azioni di Palantir Technologies (PLTR +13%) sono corse più alto oggi, raggiungendo livelli mai visti dall’inizio del 2021 prima che la scadenza del periodo di blocco dell’IPO della società accendesse un’ondata di vendite. L’inclusione nell’S&P 500 annunciata venerdì dopo la chiusura sta dando il fiamme alle azioni. I mormorii che lo sviluppatore di software AI potrebbe essere sull’S&P sono iniziati dopo aver consegnato il suo secondo trimestre consecutivo di redditività GAAP nel 1Q23 e ha osservato che la redditività dovrebbe persistere nei prossimi trimestri.

Ci è piaciuto PLTR dalla fine dell’anno scorso dopo aver mostrato un eccezionale slancio di inversione di tendenza capitalizzando il ronzio dell’IA. Tuttavia, con le azioni ora ai massimi pluriennali dopo aver più del raddoppiato l’anno fiscale, la valutazione di PLTR è salata a livelli alti, scambiando a un multiplo delle vendite di 27x FY24, considerevolmente superiore ad alcuni dei suoi colleghi, tra cui Snowflake (SNOW) a 11x e IBM (IBM) a 3x.

- PLTR ha costantemente dimostrato i suoi vantaggi tecnologici nel campo dell’IA, offrendo recentemente un altro solido ritmo nel secondo trimestre. Le entrate governative e commerciali hanno mantenuto lo slancio al rialzo, con i clienti commerciali in aumento del 41% anno/anno a 593. Il lato commerciale di PLTR tende ad essere l’obiettivo principale ogni trimestre, dato che l’azienda comanda già una presenza dominante negli Stati Uniti. Governo.

- PLTR è cresciuto con profitto, espandendo recentemente i suoi margini operativi rettificati di 12 punti all’anno al 37%, segnando il suo settimo trimestre consecutivo di espansione del margine. Come azienda focalizzata sul software, PLTR ha ampio spazio per mantenere la sua redditività.

- L’Europa è stata un ostacolo costante, che ha pesato sulla crescita commerciale internazionale, che ha composto un relativamente piccolo 22% dei giri totali nel secondo trimestre. All’inizio di quest’anno, PLTR ha avvertito che i venti contrari in Europa potrebbero persistere dato che la regione si stava dirigendo verso una crescita del PIL dello 0% nei prossimi due anni. Tuttavia, per compensare questa sfida, PLTR si è spostato rapidamente in Asia e in Medio Oriente, contribuendo a mantenere la crescita positiva delle sue entrate commerciali internazionali nel secondo trimestre al 15% anno/anno.

Nel complesso, PLTR rimane una solida scommessa sull’ intelligenza artificiale a lungo termine. Il software dell’azienda si differenzia da altri strumenti di analisi dei dati basati sull’intelligenza artificiale e ha già penetrato nelle imprese globali, tra cui ExxonMobil (XOM) e United Airlines (UAL), per non parlare delle numerose agenzie governative, compresi gli Stati Uniti. Governo federale. Tuttavia, ai livelli attuali, esortiamo cautela a breve termine poiché eventuali crepe minori possono aprire PLTR fino a un’ondata di vendite. A seguito di massicci afflussi di capitale nel settore dell’IA, i clienti vorranno vedere presto un sano ritorno sull’investimento. Anche se PLTR continua a mostrare il suo vantaggio competitivo, se il quadro generale dell’IA inizia a deteriorarsi, PLTR sarà probabilmente spazzato via dalla pressione di vendita, soprattutto data la sua attuale valutazione.

05/09/24 Barron’s: L’intelligenza artificiale non può essere all’altezza delle aspettative del mercato. Perché la festa è finita.

Informazioni sull’autore: Amar Bhidé è professore di politica sanitaria presso la Mailman School of Public Health della Columbia University e autore del prossimo libro Uncertainty and Enterprise: Venturing Beyond the Known, pubblicato dalla Oxford University Press.

Mentre parte della frenesia si è placata, l’inevitabilità della rivoluzione dell’intelligenza artificiale rimane profondamente radicata nei consigli di amministrazione delle aziende e a Wall Street. “Il rischio di investire troppo poco è nettamente maggiore del rischio di investire troppo”, ha dichiarato Sundar Pichai, CEO di Alphabet ha detto agli investitori recentemente.

Eppure, secondo l’hedge fund Elliott Management, molti dei presunti usi dell’IA “non saranno mai efficienti in termini di costi, non funzioneranno mai correttamente, assorbiranno troppa energia o si riveleranno inaffidabili”, ha affermato il Financial Time.

L’entusiasmo per l’intelligenza artificiale è stato alla base della recente straordinaria corsa al rialzo del mercato azionario, anche se la crescita è ora rallentata. Al 3 settembre, tutti i titoli dei Magnifici Sette, ad eccezione di Tesla, erano on ribasso, con Nvidia in testa alle perdite.

La storia – e l’inevitabile inaffidabilità dei motori statistici dell’IA – supporta la visione di Elliott. L’intelligenza artificiale è un’azienda già matura. Non è pronto per una ipercrescita che giustificherebbe le aspettative esagerate del mercato.

Negli ultimi 70 anni, gli innovatori dell’intelligenza artificiale hanno lavorato duramente per combinare la capacità del computer digitale di manipolare in modo impeccabile 1 e 0 con l’imprecisione del pensiero e del discorso umano.

Le prime applicazioni incorporavano competenze specialistiche. Tuttavia, questo approccio era limitato a problemi come la diagnosi medica, per i quali gli esperti avevano conoscenze codificabili.

Inoltre, le approssimazioni statistiche si sono rivelate più efficaci in termini di costi rispetto all’esperienza umana codificata. L’algoritmo di ricerca di Google, che ha superato di gran lunga i catalogatori umani di Internet di Yahoo, è stato un esempio lampante.

Tuttavia, anche la dipendenza dalle approssimazioni statistiche limitava l’accuratezza. Input ambigui potrebbero rendere le applicazioni inaccettabili e inaffidabili. Le parole stampate che utilizzano caratteri standard sono meno ambigue delle parole scritte a mano. Non sorprende che il software di riconoscimento ottico dei caratteri esegua la scansione di libri e documenti stampati in modo molto più accurato rispetto ai programmi di riconoscimento della scrittura a mano. Decifrare le parole pronunciate (“lì” o “loro”?) richiede di conoscere l’intento di chi parla. Ma poiché le correlazioni statistiche non sono in grado di scoprire l’intenzione, i programmi di dettatura rimangono frustrantemente incostanti.

L’accuratezza delle applicazioni di intelligenza artificiale dipende anche dal processo che genera i dati sottostanti. La stabilità dei processi fisici, come la frenata automatica nelle automobili, la produzione di acciaio e la raffinazione del petrolio, li rende suscettibili di modelli statistici affidabili. Al contrario, la condotta umana è soggetta ai capricci e ai capricci degli atteggiamenti sociali. Le previsioni statistiche sui processi fisici tendono quindi ad essere affidabili, mentre le previsioni sul comportamento dei consumatori possono essere altamente imprecise.

Tuttavia, l’IA statistica non doveva essere infallibile.

Google e Meta Platforms si affidano all’intelligenza artificiale statistica per generare gli annunci che ora dominano Internet. Quasi ogni pubblicità che mi lanciano addosso è completamente lontana dai miei interessi. Ma la posta in gioco nel mostrare a qualcuno gli annunci sbagliati è bassa e anche il targeting selvaggiamente impreciso della pubblicità algoritmica batte l’alternativa della pubblicità cieca.

Nelle applicazioni creative, l’accuratezza dell’intelligenza artificiale può essere irrilevante. Non ci sono effetti speciali o animazioni corretti nei videogiochi e nei cartoni animati. Non esiste un punto di riferimento oggettivo per il restauro di vecchie copie di film: chissà com’era l’originale? Il ripristino automatizzato dell’intelligenza artificiale vince perché è molto più economico e veloce del ripristino umano.

Man mano che gli innovatori risoluti imparavano gradualmente dove i vantaggi superavano i loro limiti, l’IA è diventata onnipresente. Nel 2006, filosofo futurista Nick Bostrom ha osservato che l’IA era “filtrata in applicazioni generali, spesso senza essere chiamata IA perché una volta che qualcosa diventa abbastanza utile e abbastanza comune non è più etichettato come IA”.

L’iPhone di Apple del 2007 ha messo il turbo all’intelligenza artificiale. Quasi tutte le app per smartphone, dagli SMS al sexting, dalla mappatura al matchmaking, dall’editing video allo streaming, hanno incorporato l’intelligenza artificiale. E le app per smartphone abilitate all’intelligenza artificiale, come Uber e Airbnb, hanno rivoluzionato i trasporti e il turismo. La ricerca mobile e i social media hanno schiacciato i media e la pubblicità tradizionali.

Nonostante il suo uso già diffuso, gli appassionati ritengono che l’intelligenza artificiale sia ancora agli inizi. Un imprenditore veterano del software sostiene che “le incarnazioni precedenti, come il ripiegamento delle proteine, erano esoteriche”. Ma ora i modelli linguistici di grandi dimensioni, o LLM, hanno aggiunto interfacce di chat accessibili al grande pubblico. “La vera creatività viene dalle persone che lo usano e suggeriscono nuovi usi, piuttosto che dagli ingegneri che lo creano”, ha detto l’imprenditore.

L’analogia con l’invenzione dei fogli di calcolo nel 1979 è seducente. I fogli di calcolo avevano interfacce utente semplici che consentivano alle persone con competenze tecniche limitate di creare programmi utili. Offrendo un valore convincente per le applicazioni che non richiedevano costosi mainframe, sono diventati una “killer app” per i personal computer.

Gli LLM hanno interfacce utente ancora più semplici e naturali rispetto ai fogli di calcolo. Eppure, sotto il cofano, gli LLM eseguono motori statistici con gli stessi problemi statistici che delineavano l’ambito pratico delle precedenti applicazioni di intelligenza artificiale. Come con l’IA precedente, gli LLM possono brillare in applicazioni creative, come la generazione di immagini, dove la precisione non è il fattore decisivo. Al contrario, come con altri modelli statistici di intelligenza artificiale, input e risultati ambigui ne fanno deragliare l’affidabilità. Non possono apprendere dai dati generati da un processo instabile o dipendono fortemente dal contesto.

Gettare ogni tipo di dati possibile nei vasi di addestramento degli LLM non ne migliora l’accuratezza e l’affidabilità. I dati medici non migliorano le risposte a domande legali o ingegneristiche. La formazione sulla letteratura swahili non affina i riassunti statistici delle opere di Shakespeare.

Negli usi a basso rischio, le persone tollereranno gli errori LLM come fanno con i correttori di completamento automatico nei loro messaggi di testo. La domanda multimiliardaria è se i benefici derivanti dagli usi a basso rischio possano coprire i costi.

I fogli di calcolo offrivano un’affidabilità di classe mainframe su personal computer economici. Al contrario, gli LLM richiedono agli utenti di acquistare hardware più costoso. Inoltre, l’hardware dell’utente rappresenta una frazione dei costi di costruzione, formazione e gestione degli LLM. Nonostante il clamore, gli LLM non sono come le invenzioni a corrente alternata di Nikola Tesla che Drasticamente cambiato L’economia dell’elettrificazione.

Per ora, gli investitori maniacali e i monopolisti stanno sovvenzionando massicciamente gli usi antieconomici dell’IA. Cosa succede quando la musica si ferma e gli investitori si rendono conto che alberi già alti non possono germogliare come alberelli, tanto meno crescere fino al cielo?

Commenti di ospiti come questo sono scritti da autori esterni al Barron’s

redazione. Riflettono la prospettiva e le opinioni degli autori. Invia proposte di commento e altri feedback a

ideas@barrons.com

.

29/08/24 Barron’s: Perché dovresti ignorare il calo delle azioni di Nvidia dopo i guadagni e prepararti per il prossimo grande chip dell’IA

DiTae Kim

Gli investitori dovrebbero ignorare la volatilità delle azioni legata ai risultati a breve termine del produttore di chip e concentrarsi invece sullo sfondo migliore per il boom dell’intelligenza artificiale e la GPU di nuova generazione di Nvidia, che è adatta alle applicazioni di intelligenza artificiale.

Mentre Apple e Microsoft – le altre due società del valore di circa 3 trilioni di dollari insieme a Nvidia – hanno registrato una crescita dei ricavi anno su anno del 5% e del 15%, rispettivamente, per i loro ultimi trimestri, Nvidia continua a sovraclassare i suoi colleghi, offrendo risultati storicamente senza precedenti per un’azienda tecnologica delle sue dimensioni.

Mercoledì, Nvidia ha riportato una crescita dei ricavi anno su anno del 122% a 30 miliardi di dollari nel suo secondo trimestre fiscale, che si è concluso a luglio. La sua attività di data center, guidata dalla domanda di intelligenza artificiale, è cresciuta ancora di più, al 154%. La società ha anche fornito una forte prospettiva per il trimestre in corso, superando le aspettative di Wall Street, e ha annunciato che il suo consiglio ha autorizzato un ulteriore programma di riacquisto di azioni da 50 miliardi di dollari.

Le azioni Nvidia sono inizialmente scese fino al 6% nel trading after-hour dopo i risultati, con alcuni analisti che hanno notato che nei precedenti trimestri i risultati battevano in percentuale maggiore le stime degli analisti.

Ma credo che qualsiasi scetticismo sia ingiustificato alla luce di ciò che abbiamo imparato dal rapporto sugli utili e dal commento di Nvidia sulla sua prossima unità di elaborazione grafica Blackwell, che dovrebbe fornire un altro grande passo avanti nella crescita l’anno prossimo.

In primo luogo, c’è un’alta certezza per quanto riguarda le intenzioni di spesa dei grandi clienti tecnologici di Nvidia, tra cui Alphabet, Microsoft e Meta Platforms, che hanno tutti affermato di aver pianificato di investire in modo aggressivo nell’infrastruttura di intelligenza artificiale in futuro. Microsoft ha anche affermato che la capacità è stata limitata per i servizi Azure AI, il che significa che l’azienda non ha abbastanza server GPU AI per soddisfare la domanda. La direzione di Meta ha detto che prevedeva di “aumentare significativamente” gli investimenti nell’infrastruttura di intelligenza artificiale l’anno prossimo.

L’altra domanda principale nella mente degli investitori è stata la tempistica del lancio di Blackwell. Nvidia ha riconosciuto mercoledì di aver dovuto cambiare il design della maschera del chip Blackwell, un modello di produzione utilizzato per stampare circuiti su wafer di chip, per migliorare i rendimenti di produzione. La buona notizia è che la correzione è completa e l’azienda si aspetta “diversi miliardi di dollari” di entrate dalle spedizioni di Blackwell durante il quarto trimestre, con una rampa di produzione più grande nei trimestri successivi.

Il CEO di Nvidia Jensen Huang è stato esplicito sul potenziale di crescita di Blackwell nella teleconferenza sugli utili con investitori e analisti: “Il cambiamento alla maschera è completo. Non sono stati necessari cambiamenti funzionali”, ha detto. “Ci aspettiamo di far crescere la nostra attività di data center in modo piuttosto significativo l’anno prossimo. Blackwell sarà un punto di svolta completo per l’industria.”

Le prestazioni di Blackwell sono probabilmente una grande ragione per cui la domanda probabilmente supererà la capacità di Nvidia di produrre la sua GPU di nuova generazione. Questa settimana, Nvidia ha rivelato i primi dettagli sulle prestazioni di Blackwell su un benchmark AI standard del settore chiamato MLPerf, che ha mostrato che la GPU è fino a quattro volte più veloce delle GPU di oggi nei modelli di intelligenza artificiale in esecuzione.

La tempistica esatta delle spedizioni di Blackwell, sia che siano ritardate di poche settimane o mesi, non ha molta importanza a lungo termine finché la domanda di GPU rimane robusta e l’azienda genera una forte crescita per l’intero anno 2025. Questo è ciò che guiderà il prezzo delle azioni di Nvidia.

Nvidia ha avuto “un altro trimestre di battuta/aumento straordinariamente forte per il leader di mercato nei primi inning delle inflessioni simultanee nel calcolo accelerato [basato su GPU] e nell’IA generativa”, ha scritto l’analista di TD Cowen Matthew Ramsay in una nota ai clienti, aggiungendo che il ritardo minore è ora risolto durante “l’impennata di calcolo del data center più grande/più veloce della storia”.

Tutte le ultime prove suggeriscono che il potenziale di crescita di Nvidia per il prossimo anno sta migliorando, non peggio.

Scrivi a Tae Kim a tae.kim@barrons.com

29/08/24 Barron’s: La reazione del mercato ai guadagni di Nvidia è sana. Cosa dice sul boom dell’IA.

La reazione del mercato ai guadagni di Nvidia di mercoledì è stata prevedibile date le recenti risposte ai numeri di alcuni artisti stellari in questa stagione degli utili.

La società ha riferito che il profitto è raddoppiato nell’ultimo anno. Era meglio delle stime di consenso su Wall Street. I margini sono superiori al 60%. Eppure il titolo è sceso nel trading fuori orario a seguito del rapporto. Microsoft, Amazon e Alphabet hanno avuto esperienze simili nelle ultime settimane.

La prima cosa da notare è che a volte accadono cose come questa: i trader compreranno un’azione in previsione di un evento solo per venderla quando effettivamente accade, bloccando i guadagni quando lo fanno. Potrebbe esserci un po’ di questo che sta succedendo qui.

Gli investitori hanno anche dovuto digerire il deposito del bilancio ritardato e un rapporto di un venditore allo scoperto su Super Micro Computer un’altra società di intelligenza artificiale specializzata nella creazione di server. Questo, insieme a Nvidia, potrebbe portare alcuni a preoccuparsi che il boom dell’IA si stia trasformando in fallimento.

Questo è il motivo per cui la mossa delle azioni Nvidia è in realtà un buon segno. Dimostra che l’hype intorno all’IA non è una frenesia speculativa, almeno non ancora.

In una tipica bolla, diciamo azioni Internet negli anni ’90, o tulipani olandesi nel XVII secolo, le persone continuano a comprare le attività solo perché pensano che i prezzi continueranno a salire. Ad un certo punto, raggiungono un momento di Minsky. Prende il nome dall’economista statunitense Hyman Minksy, questo è il punto in cui gli investitori si rendono improvvisamente conto che il valore di quelle cose non è neanche lontanamente vicino ai prezzi che le persone stanno pagando e il crollo segue.

Non è quello che sta succedendo ora, sembra più che i trader si stiano impegnando per valutare se il prezzo di Nvidia è giustificato dopo la sua corsa spettacolare. Il titolo ha guadagnato il 154% quest’anno. Due anni fa, un’azione costava circa 15 dollari; oggi è di circa 120 dollari, rettificato per i fraflimenti azionari.

Quindi una pausa per riflettere sembra sano, anche se Nvidia può ancora vantare una rapida crescita e clienti ben finanziati come Google, Meta Platforms e Microsoft. Almeno gli investitori non si stanno facendo trasportare.

Le entrate del produttore di chip crescono man mano che la domanda di intelligenza artificiale accelera

Nvidia ha detto che le start-up e le aziende stanno implorando i suoi chip per data center AI e che le entrate e i guadagni sono più che raddoppiati nel trimestre di luglio. Mentre gli investitori erano preoccupati per la quantità di denaro che si riversa nello spazio dell’intelligenza artificiale, il CEO di Nvidia Jensen Huang ha affermato che lo slancio per l’IA generativa sta accelerando.

- Nvidia ha registrato un fatturato record del trimestre di luglio di 30 miliardi di dollari e guadagni rettificati migliori del previsto di 68 centesimi per azione. Ma alcuni investitori si sono concentrati sul rallentamento della crescita di trimestre in trimestre, notando che le entrate sono state in aumento del 15% rispetto al primo trimestre fiscale rispetto a un guadagno dell’88% un anno prima.

- La GPU Blackwell di nuova generazione di Nvidia è fino a quattro volte più veloce della sua attuale GPU H100 su MLPerf, un punto di riferimento del settore per misurare le prestazioni di intelligenza artificiale e apprendimento automatico. Prevede di aumentare la produzione di chip nel quarto trimestre e prevede di spedire “diversi miliardi di dollari” di entrate di Blackwell.

- Gli investitori hanno anche notato che il margine operativo di Nvidia, secondo la contabilità generalmente accettata, si è ridottoal 62% dal 64,9% del trimestre precedente, ma è passato dal 50% dell’anno scorso. Il consiglio di amministrazione di Nvidia ha approvato ulteriori 50 miliardi di dollari in riacquisti di azioni, senza una data di scadenza. Il suo attuale riacquisto di azioni aveva 7,5 miliardi di dollari rimasti.

- Huang ha venduto 4,8 milioni di azioni Nvidia per 580 milioni di dollari tra il 14 giugno e il 9 agosto. Le transazioni sono state effettuate nell’ambito di un piano di trading Huang adottato a marzo che esegue automaticamente operazioni azionarie in condizioni prestabilite, eliminando qualsiasi vantaggio dalle informazioni materiali non pubbliche.

Cosa c’è dopo: per il trimestre in corso, Nvidia prevede un intervallo di entrate con 32,5 miliardi di dollari a metà, al di sopra delle aspettative. Huang ha detto che le capacità del modello AI continuano a migliorare man mano che le aziende aggiungono più potenza di calcolo e dati durante la formazione di nuovi modelli.

13/08/24 Barron’s: Acquista Azioni Micron, Dice L’analista. E questo per la domanda di Server AI.

DaTae KimSegui

Micron Technology MU è pronto a diventare un vincitore della crescente domanda di semiconduttori di intelligenza artificiale, secondo New Street Research.

Martedì, l’analista Pierre Ferragu ha riaffermato un rating Buy sul titolo e ha ribadito il suo prezzo obiettivo di 150 dollari.

Nota che le prospettive di memoria per i data center per la seconda metà del 2024 sono “forti su tutti i fronti con la corsa dell’IA e il recupero del server tradizionali” e prevede che Micron continuerà a battere le aspettative nei prossimi trimestri.

Ferragu stima che la domanda di memoria nel mercato dei server AI sarà aumentata di 14 volte nei prossimi quattro anni a 50 miliardi di dollari nel 2027 da 3,5 miliardi di dollari nel 2023.

“L’aumento del contenuto HBM [memoria ad alta larghezza di banda] nei server AI è un motore di crescita pluriennale per la memoria”, ha scritto.

Micron è leader nei mercati della DRAM, che viene utilizzata nei computer desktop e nei server, e della memoria flash, che si trova negli smartphone e nei dischi rigidi a stato solido.

Le azioni Micron sono aumentate del 50% negli ultimi 12 mesi, rispetto a un aumento del 34% per l’ETF iShares Semiconductor SOXX

Scrivi a Tae Kim a tae.kim@barrons.com

30/07/24 MarketWatch: i guadagni di Microsoft e AMD mostrano che l’IA rimane un’illusione ottica

Wall Street vuole numeri precisi, e finora, questo proviene principalmente da società di hardware e produttori di chip

La dicotomia nelle reazioni di Wall Street ai risultati di Microsoft Corp. e Advanced Micro Devices Inc. – due giganti della tecnologia che hanno investito molto nell’IA – è un perfetto esempio del gioco dell’ottica dell’IA.

Molti produttori di chip e aziende hardware che vendono prodotti reali per l’esecuzione di applicazioni di intelligenza artificiale nei centri dati sono stati in grado di quantificare lo specifico contributo alle entrate, mentre gli sviluppatori di software che non riducono le entrate sui prodotti relativi all’intelligenza artificiale non sono così chiari. Questo è uno dei motivi per cui gli investitori hanno spinto i valori di molti produttori di chip invece delle società di software, molte delle quali non stanno divulgando entrate specifiche dell’IA.

Martedì, AMD ha aumentato le sue previsioni per il suo nuovo chip grafico AI, l’MI300, per la seconda metà dell’anno, e ha affermato che il chip, più il suo chip Epyc per i server, stavano alimentando la sua più grande crescita del data center di sempre. L’amministratore delegato di AMD Lisa Su ha aumentato le sue previsioni a 4,5 miliardi di dollari per le entrate quest’anno dai chip di accelerazione grafica MI300 dell’azienda utilizzati nei data center di intelligenza artificiale. Questo è aumentato rispetto agli oltre 4 miliardi di dollari in precedenza e le azioni di AMD sono aumentate del 7% nel trading after-hour

Nel frattempo, il gigante del software Microsoft ha avuto una leggera mancanza di entrate nella sua attività di servizi cloud di Azure, con una crescita delle entrate in un po’ al 30% e una previsione per un’altra leggera decelerazione alla crescita del 28%-29% nel prossimo trimestre. Il Chief Financial Officer di Microsoft Amy Hood ha citato alcuni rallentamenti in Europa sull’utilizzo del centro dati non-AI e sui vincoli di capacità su Azure, poiché l’azienda spende per costruirlo ulteriormente.

Pur essendo in grado di quantificare la sua crescita cloud-business, Microsoft non ha fornito entrate sul software Copilot 365, il suo strumento per le imprese e i consumatori per consentire l’uso dell’IA. “I clienti copilota sono aumentati di oltre il 60% trimestre su trimestre”, ha detto l’amministratore delegato di Microsoft Satya Nadella agli analisti durante la teleconferenza sugli utili. “I consumatori hanno utilizzato Copilot per creare oltre 12 miliardi di immagini e condurre 13 miliardi di chat fino ad oggi, in aumento del 150% dall’inizio dell’anno solare”.

Ma poiché non è ancora una voce di per sé, è difficile quantificare i dati finanziari del Copilot di Microsoft. Un analista ha chiesto “cosa ci vorrà perché l’IA [generativa] diventi più reale” in tutto il settore.

“Guarda, alla fine della fiera , la generazione AI è solo software”, ha detto Nadella, aggiungendo che si sta traducendo in un “tasso di crescita più veloce di qualsiasi altra generazione precedente di software che abbiamo lanciato come suite in M 365”.

Ma Wall Street vuole numeri precisi, e finora, i numeri più precisi e i dati sulle entrate dei prodotti provengono da aziende hardware e produttori di chip. Gli utili di Nvidia Corp – molto attesi dal mercato – usciranno il 28 agosto.

Se i CEO delle società di software vogliono le valutazioni delle società di hardware o semiconduttori in questo momento, probabilmente si rendono conto che dovrebbero condividere più dettagli finanziari sulle loro offerte di intelligenza artificiale. Se ciò accadrà o meno, o se il ritorno sull’investimento di un cliente sarà il miglior indicatore, è una grande domanda che gli investitori continuano a porsi.

25/07/24 Barron’s: Le vendite di chip AI di AMD possono essere forti, ma l’analista nota i rischi

DaTae Kim

AMD venderà più chip di intelligenza artificiale del previsto quest’anno, dice Susquehanna.

Giovedì, l’analista Christopher Rolland ha ribadito il suo rating positivo per l’AMDstock e ha riaffermato il suo obiettivo di prezzo di 200 dollari.

Ad aprile, la direzione di AMD aumentato la sua previsione per il 2024 per le entrate dell’unità di elaborazione grafica AI del centro dati a più di 4 miliardi di dollari da 3,5 miliardi di dollari. L’MI300, una GPU per data center, è l’offerta di AMD per alimentare progetti di intelligenza artificiale e applicazioni di intelligenza artificiale.

Rolland si aspetta che AMD aumenti di nuovo la sua guida per l’MI300 quando la società riporterà i guadagni la prossima settimana, ma non è sicuro.

“Senza grande fiducia, ci aspettiamo a malincuore un ulteriore aumento di 500 milioni di dollari”, ha scritto, aggiungendo che la guida del centro dati sarà l’obiettivo principale per gli investitori.

Che AMD aumenti le sue previsioni la prossima settimana o meno, l’analista stima che l’azienda venderà 5 miliardi di dollari di GPU per data center quest’anno rispetto all’attuale orientamento di oltre 4 miliardi di dollari.

Rolland ha anche detto che ora ci sono rischi crescenti per il business della CPU di AMD, notando il ritardo nel lancio del prodotto.

Mercoledì, un dirigente di AMD ha annunciato che la consegna dei nuovi processori desktop della serie Ryzen 9000 dell’azienda slitterà di una o due settimane all’inizio di agosto poiché le spedizioni iniziali “non hanno soddisfatto” le sue aspettative di qualità.

Le azioni AMD sono aumentate del 26% negli ultimi 12 mesi, rispetto all’aumento del 32% dell’ETF iShares Semiconductor

15/07/24 Corriere Economia: Metti l’AI nei portafogli

14/07/24 E se invece guadagnare con l’AI provassimo guadagnare grazie ai suggerimenti dell’AI?

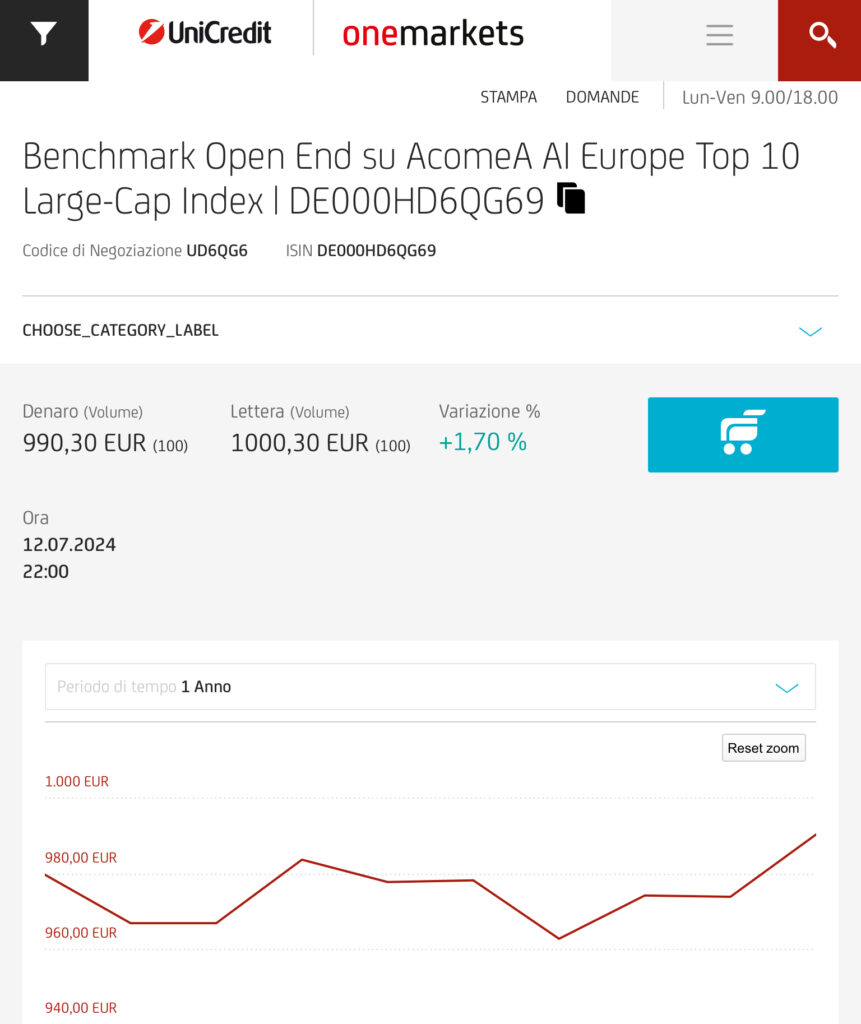

UniCredit e AcomeA hanno lanciato un certificato aperto su 10 azioni europee che vengono settimanalmente selezionate fra le 50 dell’ EURO STOXX 50 da un algoritmo di Intelligenza artificiale.

Di fatto e’ un fondo con dei costi di gestione piu’ bassi – 0.76% annuo – rispetto ai fondi – ma superiori a quelli degli ETF – e con l’innegabile vantaggio che in caso di guadagno si possono compensare eventuali minusvalenze.

10/07/24 Briefing.com: Advanced Micro rivede i massimi di più mesi dopo il suo acquisto di Silo AI (AMD) da 665 milioni di dollari

L’acquisto in contanti di Silo AI di circa 665 milioni di dollari di Advanced Micro (AMD +3%) sta stimolando una sana attività di acquisto oggi mentre le azioni si spostano ai loro migliori livelli dall’inizio di aprile, prima che i numeri del primo trimestre innescassero una svendita. La risposta energica all’acquisizione da parte di AMD di un’organizzazione legata all’IA è alla base di un appetito sostenuto tra gli investitori per tutto ciò che riguarda l’IA. Mentre i rendimenti della tecnologia devono ancora essere significativi, il mercato è più che disposto a comprare ora in previsione di una crescita esplosiva lungo la linea.

L’IA rimarrà al centro dell’attenzione verso la stagione dei guadagni, che prenderà il via alla fine di questa settimana. Le grandi aziende tecnologiche stanno cercando di superarsi a vicenda in una corsa per essere il leader dominante nell’IA. La battaglia di AMD è attualmente con NVIDIA (NVDA), le cui GPU, inclusa la sua prossima piattaforma Blackwell, sono rimaste la scelta migliore tra i giganti della tecnologia che costruiscono la loro infrastruttura AI. Tuttavia, AMD si è in genere trovata al secondo posto dopo NVIDIA, non è un brutto posto dove stare se l’IA si rivela redditizia come molti si aspettano.

- Tuttavia, AMD non è compiacente nel rimanere al numero due. Accettando di acquisire Silo AI, che si presenta come il più grande laboratorio di intelligenza artificiale privato d’Europa, lavorando con ogni verticale, dall’automotive all’energia, AMD prevede di fortificare in modo significativo la sua attività di intelligenza artificiale.

- Silo AI è stata fondata nel 2017 e da allora si è impegnata nello sviluppo di modelli di intelligenza artificiale su misura. Alcuni dei suoi clienti passati includono Unilever (UL), dove Silo ha sviluppato uno strumento ML per migliorare l’efficienza dell’imballaggio, e Intel (INTC), che ha utilizzato la tecnologia di controllo qualità di Silo.

- Con esperienza nel lavorare con un importante progettista e produttore di chip in Intel, Silo AI sembra essere una soluzione solida per AMD. Il laboratorio probabilmente lavorerà fianco a fianco con AMD che integra rapidamente l’intelligenza artificiale nei suoi prodotti, portando forse a futuri guadagni di prestazioni rispetto a NVIDIA, forse a prezzi più bassi.

Anche con l’IA in fase di sperimentazione, le aziende si stanno rivolgendo alla tecnologia per non essere lasciate indietro in modo competitivo se l’IA decolla in modo significativo. I progettisti di chip, tra cui NVDA, AMD e INTC, saranno ciascuno in competizione per una fetta della torta AI, e qualsiasi vantaggio minore potrebbe tradursi in notevoli guadagni finanziari. Accettando di aggiungere Silo AI alla sua attività, AMD sta facendo il passo necessario per ottenere un potenziale vantaggio rispetto ai suoi colleghi. Se l’acquisto alla fine si tradurrà in un sano ritorno sull’investimento deve ancora essere visto. Tuttavia, stare seduti non è un’opzione per i produttori di chip durante una tale frenesia legata all’IA.

05/07/24 TomsHardware: L’industria dell’IA deve guadagnare 600 miliardi di dollari all’anno per pagare la massiccia spesa hardware: i timori di una bolla di intelligenza artificiale si intensificano sulla scia del rapporto Sequoia

da Anton Shilov

La bolla dell’IA sta raggiungendo un punto di svolta?

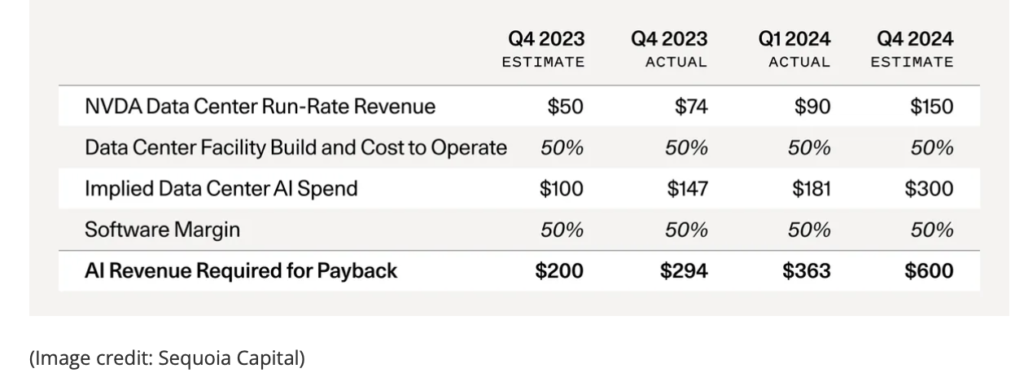

Nonostante i massicci investimenti nell’infrastruttura di intelligenza artificiale da parte di giganti dell’alta tecnologia, la crescita dei ricavi dell’IA deve ancora materializzarsi, indicando un divario significativo nel valore dell’utente finale dell’ecosistema. In effetti, David Cahn, un analista di Sequoia Capital, ritiene che le aziende di intelligenza artificiale dovranno guadagnare circa 600 miliardi di dollari all’anno per pagare la loro infrastruttura di intelligenza artificiale, come i centri dati.

Nvidia ha guadagnato 47,5 miliardi di dollari di entrate hardware per data center l’anno scorso (con la maggior parte dell’hardware che sono GPU di elaborazione per applicazioni AI e HPC). Aziende come AWS, Google, Meta, Microsoft e molte altre hanno investito pesantemente nella loro infrastruttura di intelligenza artificiale nel 2023 per applicazioni come ChatGPT di OpenAI. Tuttavia, guadagneranno quell’investimento? David Cahn crede che questo potrebbe significare che stiamo assistendo alla crescita di una bolla finanziaria.

Matematica semplice

La matematica di Cahn è relativamente semplice. In primo luogo, raddoppia la previsione delle entrate run-rate di Nvidia per coprire i costi totali del centro dati AI (le GPU sono la metà; il resto include energia, edifici e generatori di backup). Quindi, raddoppia di nuovo quell’importo per tenere conto di un margine lordo del 50% per gli utenti finali, come le startup o le aziende che acquistano AI computing da aziende come AWS o Microsoft Azure, che devono anche fare soldi.

I fornitori di cloud, in particolare Microsoft, stanno investendo pesantemente nelle scorte di GPU. Nvidia ha riferito che metà delle entrate del suo data center proviene da grandi fornitori di cloud, con Microsoft da sola che probabilmente contribuisce a circa il 22% delle entrate del quarto trimestre FY2024 di Nvidia. Nel frattempo, l’azienda ha venduto circa 19 miliardi di dollari di GPU per data center nel primo trimestre dell’anno fiscale 2025.

L’introduzione dei processori B100/B200 di Nvidia, che promettono prestazioni 2,5 volte migliori mentre costano solo il 25% in più, probabilmente guiderà ulteriori investimenti e creerà un’altra carenza di forniture.

Secondo l’analista, OpenAI, che utilizza l’infrastruttura Azure di Microsoft, ha visto un sostanziale aumento delle entrate, da 1,6 miliardi di dollari alla fine del 2023 a 3,4 miliardi di dollari nel 2024. Questa crescita sottolinea la posizione dominante di OpenAI sul mercato, superando di gran lunga altre startup che stanno ancora lottando per raggiungere un traglio di 100 milioni di dollari. Eppure gli investimenti nell’hardware AI stanno crescendo.

Anche le proiezioni ottimistiche per le entrate dell’IA delle grandi aziende tecnologiche non sono all’altezza, dice Cahn. Supponendo che Google, Microsoft, Apple e Meta generino ciascuno 10 miliardi di dollari all’anno dall’IA e altre aziende come Oracle, ByteDance, Alibaba, Tencent, X e Tesla generino 5 miliardi di dollari ciascuna, rimane un divario di 500 miliardi di dollari.

L’industria dell’IA deve imparare a guadagnare

Ci sono sfide significative alla visione ottimistica degli investimenti nell’infrastruttura di intelligenza artificiale. A differenza dell’infrastruttura fisica, l’informatica GPU AI potrebbe essere mercificata man mano che nuovi giocatori entrano in scena (AMD, Intel, per non parlare dei processori personalizzati di Google, Meta e Microsoft), in particolare nel campo dell’inferenza, portando a un’intensa concorrenza sui prezzi. Gli investimenti speculativi spesso si traducono in perdite elevate e i nuovi processori svalutano rapidamente quelli più vecchi, contrariamente al valore più stabile dell’infrastruttura fisica.

In definitiva, mentre l’IA ha un potenziale di trasformazione e aziende come Nvidia svolgono un ruolo cruciale, la strada da percorrere sarà lunga e impegnativa poiché le aziende e le startup devono ancora inventare applicazioni che fanno soldi.

Cahn ritiene che l’industria debba temperare le aspettative di rapidi profitti dai progressi dell’IA, riconoscendo la natura speculativa degli investimenti attuali e la necessità di un’innovazione sostenuta e di creazione di valore. In caso contrario, la bolla del valore di centinaia di miliardi di dollari è destinata a esplodere, portando potenzialmente a una crisi economica globale, ma stiamo speculando qui, ovviamente.

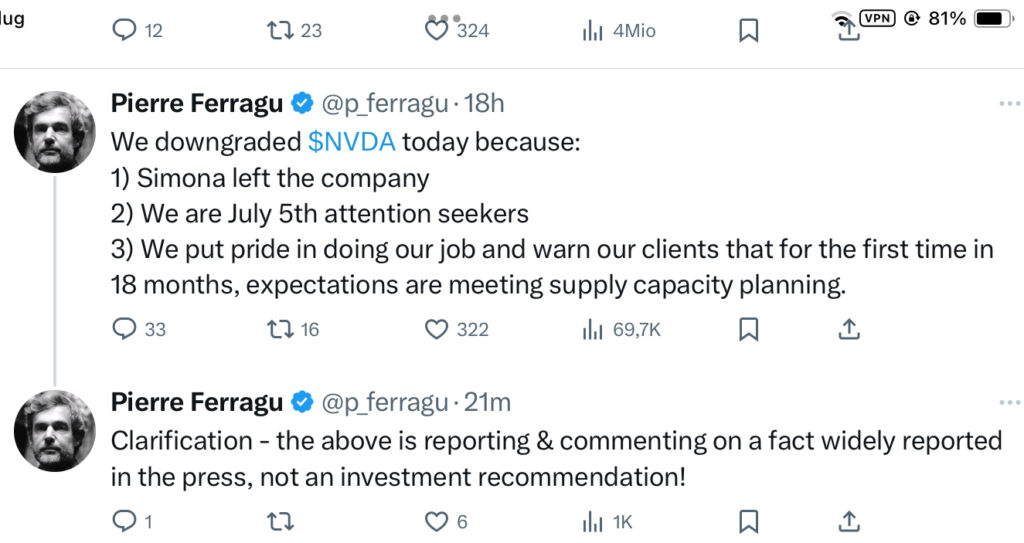

05/07/24 Varie notizie sul declassamento di Nvidia a “neutral”

- Le azioni AMD sono aumentate del 5% venerdì.

- L’analista di New Street Research Pierre Ferragamo afferma che il successo di Nvidia è già incluso nel prezzo.

- Pierre Ferragu vede molto più spazio per la crescita del prezzo delle azioni in AMD.

L’analista di New Street Research Pierre Ferragu ha abbssato il suo rating Buy suNvidia (NVDA) questo venerdì a favore di un voto neutro. La valutazione di Ferragu ha sorpreso il mercato poiché Nvidia è stata l’ovvio leader nell’attuale mercato rialzista iniziato quasi due anni fa nell’ottobre del 2022.

Ferragu non è davvero ribassista sulle prospettive di intelligenza artificiale (AI) di Nvidia, anzi, in realtà. Invece, pensa che Nvidia sia correttamente valutata al momento in base alla guida attuale. Come analista di alto livello che ha trascorso 10 anni a coprire i semiconduttori alla Bernstein, Ferragu ha detto ai clienti di concentrarsi invece su sostenitori del settore a prezzi migliori come AMD e Taiwan Semiconductor (TSM).

Farragu ha dato alle azioni AMD un obiettivo di prezzo di 235 dollari, 12 mesi e un obiettivo di 345 dollari entro la fine del 2026. Ha basato la sua valutazione su una previsione che AMD produrrà 10 dollari di utili per azione entro il 2027.

AMD ha sottoperformato il sentimento degli investitori per la sua attività di chip AI finora quest’anno, e Morgan Stanley ha recentemente declassato le azioni su tale conto.

Tuttavia, il continuo guadagno di quota di mercato di AMD all’interno del mercato delle CPU per i PC non ha motivo di fermarsi. I processori Ryzen AI 300 di nuova generazione sono progettati per elaborare meglio i carichi di lavoro AI e molti analisti pensano che potrebbero aiutare AMD a rubare ancora più quota di mercato da Intel (INTC).

Inoltre, gli investitori stanno spingendo in alto secondo produttore di chip faberless poiché si prevede che le sue GPU del data center abilitate all’IA venderanno 4 miliardi di dollari solo quest’anno.

02/06/24 MarketWatch: Si sta profilando una bolla azionaria di intelligenza artificiale? Questa è la domanda da 167 miliardi di dollari.

Le proiezioni delle spese di capitale dell’IA non sono al passo con le proiezioni delle entrate dell’IA, che secondo Barclays potrebbero incapsulare FOMO, o la paura di perdere il rialzo

La spesa frenetica per l’intelligenza artificiale guiderà importanti aumenti delle entrate per le aziende di Internet – o quei grandi spenditori non sono troppo precipitosi ?

Questa è una domanda chiave per gli investitori in questi giorni, secondo l’analista di Barclays Ross Sandler, che ha notato martedì che la matematica non sembra sommarsi. Le aspettative di Wall Street sono di circa 60 miliardi di dollari in spese di capitale incrementali per l’IA, ma solo 20 miliardi di dollari in entrate cloud incrementali per il 2026.

“Uno dei dibattiti più caldi di oggi nella comunità degli investimenti è se tutti gli investimenti in capex AI che vanno nei centri dati finiranno per essere un’overbuild della bolla [telecomunicazioni] del 2000, o se c’è abbastanza domanda di [entrate] di intelligenza artificiale da giustificarli”, ha detto Sandler in una nota ai clienti.

Rispondere a questa domanda dipende da quale scenario gli investitori ritengono più probabile quando cercano di dare un senso alle discrepanze tra la spesa prevista per l’IA e le entrate previste per l’IA. Gli investitori devono chiedere se pensano che le aspettative di reddito siano corrette, il che significa che la spesa in conto capitale è troppo alta per sostenerlo, o se le proiezioni sulle entrate sottovalutano l’impatto futuro dell’IA sui dati finanziari.

Sandler pensa che la corsa alla spesa per l’IA – un totale di 167 miliardi di dollari dall’inizio della frenesia dell’IA – potrebbe riflettere un po’ di FOMO, o la paura di perdere l’opportunità, piuttosto che uno “scenario Field of Dreams” in cui le entrate diffuse dell’IA si manifesteranno presto in grande stile.

Potresti chiamarla una domanda da 167 miliardi di dollari, anche se Sandler fa un ulteriore passo avanti nel soprannominarla “la domanda da miliardi di dollari”.

Sulla base del nostro lavoro preliminare qui, la stima di consenso per il capex AI hyperscaler nel 2026 è sufficiente per supportare Internet esistente più 12.000 nuovi prodotti AI su scala ChatGPT”, ha scritto. Ma Wall Street è preoccupata se ci saranno effettivamente da qualche parte vicino a così tante applicazioni di intelligenza artificiale che possono generare entrate, secondo Sandler.

Dal suo punto di vista, Sandler vede il potenziale per “molti nuovi servizi che porteranno alla luce alcuni di questo caso toro, ma probabilmente non 12.000 di loro”. Al di fuori della Cina, ci sono circa 50 app di consumo in generale che hanno più di 50 utenti, mentre nel mercato del software, forse qualche dozzina di grandi aziende di software insieme rastrellano circa 1 miliardo di licenze.

Con questa matematica, “anche se tutti questi prodotti sono stati sostituiti da prodotti di intelligenza artificiale concorrenti, non c’è modo che le entrate di tali prodotti di intelligenza artificiale giustifichino il limite per il 2026”, ha detto Sandler.

Riconosce che i servizi di intelligenza artificiale potrebbero finire per sfoggiare metriche di coinvolgimento molto più profonde rispetto alle loro controparti tradizionali. In un tale scenario, il possibile impatto sulle entrate dell’IA potrebbe ora essere sottovalutato. Ad esempio, nota che Character.ai vede un quinto delle richieste di inferenza giornaliere relative a ciò che Google vede, anche da una base di utenti molto più piccola.

“Solo cinque Character.ai sono gli stessi di un Google?” Sandler ha chiesto. “È piuttosto selvaggio a cui pensarci”.

Nel complesso, però, quando si tratta del grande dibattito sugli investimenti, ha scritto che lui e il suo team stanno “annusando FOMO e si aspettano che qualcuno cominci a rinsavire prossimo, ma è ancora molto presto per l’IA”.

Mentre si concentra sulle azioni di Internet, ha aggiunto che la tendenza “probabilmente non significa che Nvidia sia in qualsiasi tipo di problema a medio termine, poiché ci aspettiamo che il capex dell’IA continui ad andare forte per un paio d’anni prima che qualcuno sbatta le palpebre e tagli”.

20/06/24 Barron’s: AMD diventa ora la scelta Top dell’analista Piper a causa dei chip del server AI

DaEric J. SavitzSegui

Le azioni di Advanced Micro Devices sono scambiate in rialzo giovedì, almeno in parte grazie a una nota rialzista sul business dei server AI del produttore di chip da parte dell’analista di Piper Sandler Harsh Kumar.

Kumar, che mantiene un rating di sovrappeso e un prezzo obiettivo di 175 dollari sul titolo, ha designato AMD come la sua prima scelta di semiconduttori di grande capitalizzazione verso la seconda metà dell’anno.

In una nota di ricerca, Kumar ha notato che ha viaggiato con la gestione AMD in Europa la scorsa settimana ed è uscito “estremamente impressionato” dalla strategia dell’azienda e dal suo posizionamento competitivo sul mercato delle GPU utilizzate per le applicazioni di intelligenza artificiale, dove è una delle poche aziende che sfida Nvidiahead.

Kumar vede anche venti in coda sia per i segmenti PC di AMD che per i segmenti server convenzionali.

Ma l’IA è al centro della storia di AMD in questo momento. Kumar riferisce che AMD ha più di 100 clienti per i suoi processori AI, con la maggior parte di loro che dovrebbe aumentare l’adozione nella seconda metà del 2024. Dice che il chip MI300 di punta dell’azienda sta “performando molto bene”, con vendite che dovrebbero superare i 4 miliardi di dollari quest’anno.

Ma come AMD ha recentemente rivelato, ha una raffica di chip follow-on in arrivo, tra cui l’MI325 (previsto entro la fine dell’anno), l’MI350 (in arrivo l’anno prossimo) e l’MI400 (in programma per il 2026). Kumar sostiene che l’MI350 sarà competitivo con la linea di chip Blackwell di Nvidia, mentre l’MI400 affronta il chip di prossima generazione recentemente annunciato da Nvidia, soprannominato Rubin.

L’analista sottolinea che i clienti di AMD per i suoi chip AI includono Microsoft, Meta e Oracle.

Un altro fattore che potrebbe contribuire alla forza delle azioni AMD è un articolo del Wall Street Journal affermando che alcuni PC Samsung AI basati sui chip Snapdragon di Qualcomm stanno avendo problemi a eseguire alcune applicazioni. Questa notizia sta facendo pressione sulle azioni sia di Qualcomm che di Arm (che fornisce i progetti su cui si basano i chip di Qualcomm). Gli investitori sono stati ottimisti sulle prospettive per Qualcomm di assumere una certa quota di mercato nei processori PC di AMD e Intel.